в рамках какого подхода информация рассматривается как фундаментальное свойство материи

ИНФОРМАЦИЯ КАК СВОЙСТВО МАТЕРИИ

Современное понимание того, что такое информация и какую роль она играет в искусственных и естественных системах, сложилось не сразу; оно представляет собой совокупность знаний, полученных разными науками: физикой, биологией, философией, теорией связи и т.д.

Хотя физика старается изучать явления природы в максимально объективированной (т.е. не связанной с человеком и его воздействием на окружающий мир) форме, ей не удалось полностью исключить “человеческий фактор”. Во-первых, при экспериментальном исследовании физических явлений невозможно обойтись без измерения ряда величин, и наличие этих величин в теоретических моделях рано или поздно требует специального рассмотрения того, как именно проводятся измерения – а без влияния человека не проводятся даже автоматические эксперименты. Во-вторых, физика не могла не заняться изучением технических (т.е. созданных человеком) устройств и тут-то и “попала в ловушку”: полностью объективистский подход к машинам все равно обнаружил в их поведении следы человеческой деятельности. Впервые это произошло в термодинамике – науке, изучающей процессы в тепловых машинах. Оказалось, что без введения специального понятия энтропии невозможно дать исчерпывающего описания их действия. Скачок в понимании природы этой величины произошел, когда Л.Больцман дал ей статистическую интерпретацию (1877); уже сам Больцман обронил фразу о том, что энтропия характеризует недостающую информацию, но тогда этой фразы никто не понял.

После построения К.Шэнноном теории информации (1948), когда оказалось, что формула Шэннона для информационной энтропии и формула Больцмана для термодинамической энтропии оказались тождественными, разгорелись споры о том, является ли это совпадение чисто формальным или оно выражает глубокую связь термодинамики и теории информации. Дискуссии (в особенности благодаря работам Бриллюэна [1, 2]) привели к современному пониманию этой неразрывной связи.

Совсем с другой стороны к этой проблеме пришла философская теория познания. Изначальный смысл слова “информация” как “знания, сведения, сообщения, уведомления, известия, ведомости”, т.е. нечто присущее только человеческому сознанию и общению, начал расширяться и обобщаться. Признав, что наше знание есть отражение реального мира, материалистическая теория познания установила, что отражение является всеобщим свойством материи. Сознание человека является высшей, специфической формой отражения, но существуют и другие формы – психическая (присущая не только человеку, но и животным), раздражимость (охватывающая, кроме того, растения и простейшие организмы) и, наконец, самая элементарная форма – запечатление взаимодействия (присущая и неорганической природе, и элементарным частицам, т.е. всей материи вообще). И теперь, как только состояния одного объекта находятся в соответствии с состояниями другого объекта (будь то соответствие между положением стрелки вольтметра и напряжением на его клеммах или соответствие между нашим ощущением и реальностью), мы говорим, что один объект отражает другой, содержит информацию о другом.

Так вновь сомкнулись результаты философского и естественнонаучного исследования природы. Иначе и быть не могло – ведь предмет изучения един, хотя это изучение ведется с разных позиций и разными методами. В настоящее время информация рассматривается как фундаментальное свойство материи.

Таким образом, ясно, что роль информации в самом существовании систем, искусственных и естественных, огромна. Понятие информации, обладая всеобщностью, приобрело смысл философской категории. Для кибернетики, да и всей системологии, понятие информации столь же фундаментально, как понятие энергии для физики. Недаром признается не менее общим, чем определение А.И.Берга (см. гл.1), определение кибернетики, предложенное А.Н.Колмогоровым: кибернетика – это наука, которая занимается изучением систем любой природы, способных воспринимать, хранить и перерабатывать информацию и использовать ее для управления и регулирования.

| Подведем итог Исследуя информацию, кибернетика не открыла нового свойства материи: оно известно в философии под названием свойства отражения. Новое состоит в том, что информацию можно исследовать количественно. | Summary In studying information, cybernetics has not discovered a new property of matter: it is known in philosophy as the reflection property. What is new is its quantitative study of information. |

СИГНАЛЫ В СИСТЕМАХ

Как мы уже отмечали, для того чтобы два объекта содержали информацию друг о друге, необходимо, чтобы между их состояниями существовало соответствие: только при этом условии по состоянию одного объекта можно судить о состоянии другого. Такое соответствие может установиться только в результате физического взаимодействия между этими объектами. Редко бывает, чтобы два объекта взаимодействовали “непосредственно”: даже между печатью и документом нужен слой мастики; сквозь кинопленку до экрана проносится пучок света; от речевого аппарата оратора до ушей слушателей звук переносится колебаниями воздуха. Другими словами, соответствие между состояниями двух объектов может устанавливаться и с помощью взаимодействия с промежуточными объектами, часто даже целой совокупностью промежуточных объектов.

Итак, сигнал есть материальный носитель информации, средство перенесения информации в пространстве и времени.

Утверждая что объекты выступают в качестве сигналов, мы должны сделать уточнение. Один и тот же объект может “выступать в качестве” разных сигналов: колебания воздуха могут нести звуки музыки, речь лектора, пение птиц или шум самолета; с магнитной ленты можно стереть одну запись и сделать другую и т.д. Следовательно, в качестве сигналов используются не сами по себе объекты, а их состояния.

Далее, не всякое состояние имеет сигнальные свойства. Точнее говоря, данный объект взаимодействует не только с тем объектом, информацию о котором мы хотели бы получить, но и с другими, не интересующими нас объектами. В результате соответствие состояний ослабевает, разрушается. Условия, обеспечивающие установление и способствующие сохранению сигнального соответствия состояний, называются кодом*. Посторонние воздействия, нарушающие это соответствие, называются помехами или шумами. Нарушение соответствия может происходить не только вследствие помех, но и из-за рассогласования кодов взаимодействующих объектов. В искусственных системах, где такое согласование организуется специально, это явно видно на примере криптографии, основанной на засекречивании кодов. В природных системах согласование кодов происходит в самой структуре систем через естественный отбор различных вариантов.

Поскольку сигналы служат для переноса информации в пространстве и времени, для образования сигналов могут использоваться только объекты, состояния которых достаточно устойчивы по отношению к течению времени или к изменению положения в пространстве. С этой точки зрения сигналы делятся на два типа.

| INFORMATION информация BEARER HOLDER носитель INTERFERENCE помехи SIGNAL сигнал Информация есть свойство материи, состоящее в том, что в результате взаимодействия объектов между их состояниями устанавливается определенное соответствие. Чем сильнее выражено это соответствие, тем полнее состояние одного объекта отражает состояние другого объекта, тем больше информации один объект содержит о другом. Сигнал есть материальный носитель информации. В качестве сигналов используются состояния физических объектов или полей. Соответствие между сигналом и несомой им информацией устанавливается по специальным правилам, называемым кодом. |

К первому типу относятся сигналы, являющиеся стабильными состояниями физических объектов (например, книга, фотография, магнитофонная запись, состояние памяти ЭВМ, положение триангуляционной вышки и т.д.). Такие сигналы называются статическими.

Ко второму типу относятся сигналы, в качестве которых используются динамические состояния силовых полей. Такие поля характеризуются тем, что изменение их состояния не может быть локализовано в (неизолированной) части поля и приводит к распространению возмущения. Конфигурация этого возмущения во время распространения обладает определенной устойчивостью, что обеспечивает сохранение сигнальных свойств. Примерами таких сигналов могут служить звуки (изменение состояния поля сил упругости в газе, жидкости или твердом теле), световые и радиосигналы (изменения состояния электромагнитного поля). Сигналы указанного типа называются динамическими *.

Понятно, что динамические сигналы используются преимущественно для передачи, а статические – для хранения информации, но можно найти и противоположные примеры (динамические запоминающие устройства, письма, газеты).

| —————————— * Обратим еще раз внимание на относительность вся- кой классификации. К какому из введенных классов вы отнесете дымовые сигналы, или запах, или голо- графическое изображение? |

Сигналы играют в системах особую, очень важную роль. Если энергетические и вещественные потоки, образно говоря, питают систему, то потоки информации, переносимые сигналами, организуют все ее функционирование, управляют ею. Н.Винер, например, подчеркивал, что общество простирается до тех пределов, до каких распространяется информация. Пожалуй, это следует отнести к любой системе.

| Подведем итог Первое и, быть может, главное отличие подхода к изучению любого объекта как системы, а не как просто объекта, и состоит в том, что мы ограничиваемся не только рассмотрением и описанием вещественной и энергетической его сторон, но и (прежде всего) проводим исследование его информационных аспектов: целей, сигналов, информационных потоков, управления, организации и т.д. | Summary The first and perhaps the main distinction of the approach to studying an object as a system, and not just as a mere object, is that we do not restrict ourselves to studying and describing it only in terms of substance and energy, but also (and preferably) from the standpoint of information: its purposes, signals, information flows, control, organization, etc. |

§ 5.3. СЛУЧАЙНЫЙ ПРОЦЕСС – МАТЕМАТИЧЕСКАЯ

МОДЕЛЬ СИГНАЛОВ

Казалось бы, после того как мы установили, что сигналами служат состояния физических объектов, никаких проблем с их математическим описанием не должно быть: ведь физика имеет богатый опыт построения математических моделей физических процессов и объектов. Например, можно зафиксировать звуковые колебания, соответствующие конкретному сигналу, в виде зависимости давления x от времени t и изобразить этот сигнал функцией x(t); такой же функцией можно изобразить и статический сигнал, например запись этого звука на магнитной ленте или на грампластинке, поставив параметру t в соответствие протяженность (длину) записи.

НЕПРЕДСКАЗУЕМОСТЬ – ОСНОВНОЕ СВОЙСТВО СИГНАЛОВ

Однако имеется существенное различие между просто состоянием x(t) объекта и сигналом x(t). Оно состоит в том, что единственная функция x(t) не исчерпывает всех важных свойств сигналов. Ведь понятие функции предполагает, что нам известно значение x (либо правило его вычисления) для каждого t. Если же это известно получателю сигнала, то отпадает необходимость в передаче: функция x(t) может быть и без этого воспроизведена на приемном конце.

Следовательно, единственная однозначная функция вещественного аргумента не может служить моделью сигнала. Такая функция приобретает сигнальные свойства только тогда, когда она является одной из возможных функций. Другими словами, моделью сигнала может быть набор (или, как еще говорят, ансамбль) функций параметра t, причем до передачи неизвестно, какая из них будет отправлена; это становится известным получателю только после передачи. Каждая такая конкретная функция называется реализацией. Если теперь еще ввести вероятностную меру на множество реализаций, то мы получим математическую модель, называемую случайным процессом*.

| RANDOM случайный NOISE шум OSCILLATION колебание ENVELOPE огибающая Случайный процесс хорошо отображает главное свойство реальных сигналов – их неизвестность до момента приема. Однако некоторые модели обладают и “лишними”, не присущими реальным сигналам свойствами. Напри- мер, описание реализаций случайного процесса аналитическими функциями предполагает бесконечную точность, чего в реальности не бывает. |

| —————————— * Изложение будет вестись в предположении, что читателю знакомы элементы теории вероятностей. |

Прежде чем перейти к некоторым подробностям этой модели, отметим, что у нее все-таки имеются качества, которых нет у реальных сигналов (еще раз обратим внимание на нетождественность модели и оригинала). Дело в том, что реальные системы всегда оперируют только с конечным объемом данных, а понятие аналитической функции предполагает ее точное значение для каждого значения аргумента, т.е. такое, которое может быть представлено только с помощью бесконечного ряда цифр. Иначе говоря, в “более правильной” модели сигнала любая реализация не должна определяться с бесконечной точностью. Но пока не существует подходящего математического аппарата, столь же удобного, как математический анализ, и мы вынуждены пользоваться традиционным понятием функции. Это сопряжено с тем, что в выводах теории могут появиться (и на самом деле появляются [6]) парадоксы, природа которых связана не с реальными сигналами, а с их моделью. Во всяком случае, там, где конечная точность реальных сигналов существенна для самой постановки задачи, ее вводят в модель либо как добавочный “шум”, либо как “квантование” непрерывного сигнала (наподобие шкалы с делениями у измерительных приборов).

КЛАССЫ СЛУЧАЙНЫХ ПРОЦЕССОВ

Необходимость моделирования самых разнообразных сигналов приводит к построению частных моделей случайных процессов, т.е. наложению дополнительных ограничений на параметры распределений и на сами распределения. Перечислим наиболее важные классы случайных процессов.

Непрерывные и дискретные по времени процессы. Случайный процесс с непрерывным временем характеризуется тем, что его реализации определяются для всех моментов из некоторого (конечного или бесконечного) интервала T параметра t. Дискретный по времени процесс* задается на дискретном ряде точек временной оси (обычно равноотстоящих).

Непрерывные и дискретные по информативному параметру процессы. Эти процессы различаются в зависимости от того, из какого (непрерывного или дискретного) множества принимает значение реализация x случайной величины X.

Если же условие независимости от времени выполняется только для первых двух моментов (среднего и функции автокорреляции), то процесс называется стационарным в широком смысле (или в смысле Хинчина).

Эргодические и неэргодические процессы. На практике при описании случайных величин вместо рассмотрения их распределений часто ограничиваются только их числовыми характеристиками, обычно моментами. В тех случаях, когда распределение неизвестно, моменты (и другие числовые характеристики) можно оценить статистически.

Перенос такой практики на произвольные случайные процессы требует не только учета зависимости отстоящих друг от друга (“разнесенных”) во времени значений, но и наложения дополнительных требований. Требование совпадения величин, получающихся при усреднении по ансамблю (т.е. при фиксированном времени) и при усреднении по времени (точнее, по одной реализации), и называется условием эргодичности. Это требование можно толковать и как совпадение результатов усреднения по любой реализации*. Как и для стационарности, можно различать эргодичность в узком и широком смысле.

Можно продолжать классификацию случайных процессов и дальше, но мы будем делать это при рассмотрении конкретных вопросов.

| Подведем итог Основной результат данного параграфа состоит в том, что случайный процесс может служить математической моделью сигнала. Необходимо только следить за тем, чтобы конкретные особенности изучаемых сигналов были корректно отображены в свойствах случайного процесса. | Summary The gist of this section is the conclusion that a random process can be used as a mathematical model of a signal. But it is necessary to pay special attention to the correctness of mapping characteristics of the studied signals onto properties of the random process. |

§ 5.4. МАТЕМАТИЧЕСКИЕ МОДЕЛИ РЕАЛИЗАЦИЙ

СЛУЧАЙНЫХ ПРОЦЕССОВ

Для рассмотрения конкретных свойств систем бывает необходимо учесть особенности сигналов, циркулирующих по каналам связи этих систем. Такие особенности можно описать по-разному: просто перечислить возможные реализации (если число их конечно) либо задать в той или иной форме общие свойства реализаций, входящих в ансамбль. О дискретных процессах мы будем говорить отдельно (см. § 5.8), а сейчас рассмотрим математические модели реализаций непрерывных сигналов.

Приведем примеры, с которыми часто имеют дело в теории сигналов [7].

МОДЕЛИРОВАНИЕ КОНКРЕТНЫХ Реализаций

Гармонические сигналы. Обозначим через Sc множество всех синусоидальных сигналов:

Здесь R + – множество всех положительных действительных чисел; S называется амплитудой, w – круговой частотой (w = 2p¦, ¦ – частота), j – фазой гармонического колебания.

Модулированные сигналы. В технических системах полезная информация может переноситься каким-нибудь одним параметром “гармонического” колебания. Конечно, колебание при изменении этого параметра во времени перестает быть гармоническим. Процесс изменения параметра синусоиды называется модуляцией, а выделение этого изменения в чистом виде, как бы “снятия” модуляции, называется демодуляцией. Само колебание называется несущим. Различают амплитудную, частотную и фазовую модуляцию в зависимости от того, на какой из параметров несущего колебания “накладывают” полезную информацию (параметры с индексом 0 считаются постоянными):

Необходимо отметить, что “физический смысл” модуляции сохраняется лишь в том случае, когда модулирующий сигнал является “медленно меняющимся” по сравнению с немодулированным несущим колебанием: только при этом условии имеется возможность нестрого, “по-инженерному”, но все-таки не без смысла говорить о “синусоиде с переменной амплитудой (фазой, частотой) “. Однако удобнее все-таки говорить не о “переменной амплитуде”, а об “огибающей”, как это принято в радиотехнике.

Периодические сигналы. Сигналы называются периодическими, а временной интервал t – периодом, если

Физический смысл спектра состоит в том, что колебание х(t) представляется в виде суммы (в общем случае в виде интеграла) составляющих его гармонических колебаний с определенными амплитудами |х(¦)|, частотами ¦ и соответствующими фазами. Между х(t) и Х(¦) имеется взаимно однозначное соответствие, так как

x(t) =

Условием существования и обратимости Фурье-преобразования является ограниченность энергии сигнала (интегрируемость в квадрате функций х(t) и Х(¦)) и его непрерывность.

Если функция Х(¦) на оси ¦ имеет ограниченную “длительность” F (в смысле соотношения (7), но в частотной области), то говорят, что сигнал х(t) имеeт ограниченную полосу частот шириной F:

SB = <x: Х(¦) =

НЕКОТОРЫЕ МОДЕЛИ АНСАМБЛЯ РЕАЛИЗАЦИЙ

Нормальный шум. Удобной моделью помех и некоторых полезных сигналов является стационарный нормальный случайный процесс. Такое название вызвано тем, что случайные мгновенные значения величины х(t) предполагаются подчиненными нормальному закону (с нулевым средним), т.е. плотность распределения первого порядка выражается формулой

для плотности распределения второго порядка справедлива формула

а для n-мерной плотности – формула

Использованные здесь обозначения таковы:

N = Е(Х 2 ) – мощность шума (дисперсия мгновенных значений);

Сигнал как колебание со случайными огибающей и фазой. Понятия амплитуды и фазы, введенные первоначально для гармонических сигналов, с помощью модуляции были обобщены на сигналы, которые уже не являются гармоническими. Легко обобщить их на произвольные сигналы: пока чисто формально можно задать такие функции R(t) и j(t), чтобы для заданной функции х(t) было выполнено равенство

| Bandpass полоса частот REALIZATION реализация NARROW-BAND узкополосный Установив, что случайный процесс является приемлемой моделью сигналов, мы должны построить конкретные варианты этой модели – как на уровне описания отдельных реализаций, так и с помощью моделирования сразу всего ансамбля возможных реализаций. Современная теория сигналов предлагает модели обоих типов. |

и, сравнив его с соотношениями (1) – (4), можно трактовать R(t) и j(t) как “огибающую” и “фазу” колебания с частотой w0.

Возникает вопрос: соответствуют ли эти функции чему-нибудь реальному? Оказывается, свобода выбора в задании функций R и j при определенных условиях весьма ограничена. Эти условия мы уже упоминали как “медленность” R(t) по сравнению с cosw0t и j(t) по сравнению с w0t, а в целом этот комплекс условий в силу причин (которые мы не будем обсуждать) получил название узкополосности сигнала х(t).

Очень наглядным является векторный вариант модели (14): R и j можно рассматривать как полярные координаты некоторого вектора. Тогда всякое гармоническое колебание х(t) = Scos(w0t + j), имеющее частоту w0, изобразится как постоянный вектор с амплитудой S и углом j к направлению, принятому за ось 0х.

Пусть, например, принимаемый сигнал является суммой полезного сигнала s(t) и шума n(t):

Рассмотрим случай, когда полезный сигнал есть гармоническое колебание

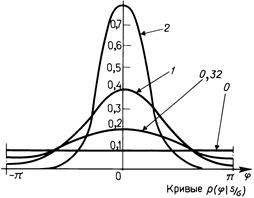

Поскольку существуют радиотехнические устройства, чувствительные только к огибающей или только к фазе принимаемого сигнала, имеет смысл рассмотреть их статистические свойства. Перейдем от декартовых координат (х, у) к полярным (R, j). Используя очевидные соотношения х = Rсоsj, y = Rsinj, dх dy = R dR dj, из равенства (17) сразу получаем распределение

Легко установить, что если S = 0 (т.е. имеется только чистый шум), то

|

5.2 ————— График плотностей распределения вероятностей для фазы колебания, являющегося аддитивной смесью смеси синусоидального сигнала с шумом 5.2 ————— График плотностей распределения вероятностей для фазы колебания, являющегося аддитивной смесью смеси синусоидального сигнала с шумом |

5.1

—————

График плотностей распределения вероятностей огибающей

смеси синусоидального сигнала с гауссовым шумом

Распределение фазы выражается формулой

Не приводя аналитических выражений для р(?) из-за их громоздкости (при необходимости см. [5]), изобразим графики этого распределения при разных S/? на рис. 5.2.